Stable Diffusion XLの1.0が公開されたので、使ってみた。

今回のバージョンから、生成プロセスがBaseとRefinerの2段階になって、GPUのRAMの使用量が増えたとのこと。学習データは512から1024になったそうで、生成も1024ドットがいいらしい。

手持ちのグラフィックボードが8GしかRAMがないので、普通に起動したら、やはりメモリ不足で動作しなかった。–medvramオプションつけたら、なんとか動いている。

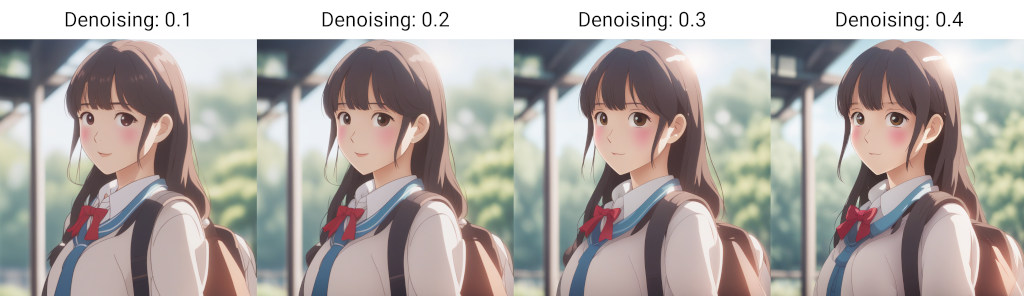

GUIからだと、肝心のRefinerプロセスが自動で起動せず、一度Baseで生成した画像をもう一度モデルを変えて画像生成させなくてはいけないんだけど、実行してもどうもあまりうまくない。Refainerをかけると細部が良くなる部分もあるが、むしろ退化している部分も多い。絵の印象も変わる。試したのがアニメ調なので、それと相性が悪いのかも。

現状ではVAEが効いていないみたいな、ちょっと色彩が薄い感じに生成されるけど、それはそれでいい感じ。

生成時間は、やはり大幅に増えている。–medvram オプションによる速度低下もあるだろうが、4,5倍の時間がかかっている印象。

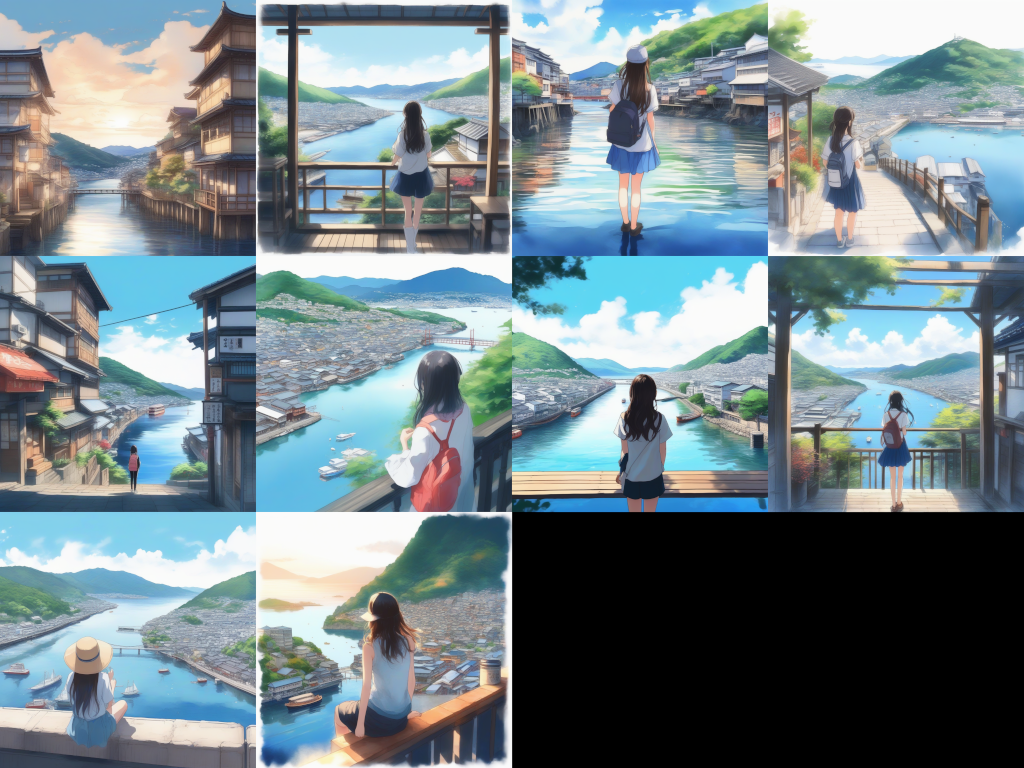

現状ではデフォルトのモデルしか試していないし、プロンプトも最小限、LoRAはもちろんないが、1つのモデルにしてはカバー範囲が広い印象。なにも設定せずに2Dイラストがポンと出てくるのはすごい進化だ。

上は、”anime, water paint, wide shot, teen girl, travel, onomichi”のシンプルなタグだけで生成したもの。

“masterpiece”だの”ultra fine”だのというオマジナイもなし。なんとなく入れた「尾道」も明らかに効いてる。

version 1.0がこのレベルで出てくるというのは想像以上だけど、逆に今でもVRAM 8Gだとギリギリ動くレベルなので、利用が進むと12Gでもきついのではないか。画像生成用にグラフィックボードはRAMの多いシリーズがほしいところ。

コメント